中国青年报客户端讯(陈书灵 中青报·中青网记者 王烨捷)只需一枚摄像头和一对耳机便能将画面转化成语言,描绘场景、提示风险,让视障者出行更安全、生活更便捷。日前,复旦大学自然语言处理实验室(FudanNLP)的师生们研发了一款基于多模态大模型的“复旦·眸思”(MouSi)系统,为视障者量身打造了“听见世界”App。预计今年3月该App将完成第一轮测试,在我国一二线城市和地区同步开启试点,根据算力情况进行推广。

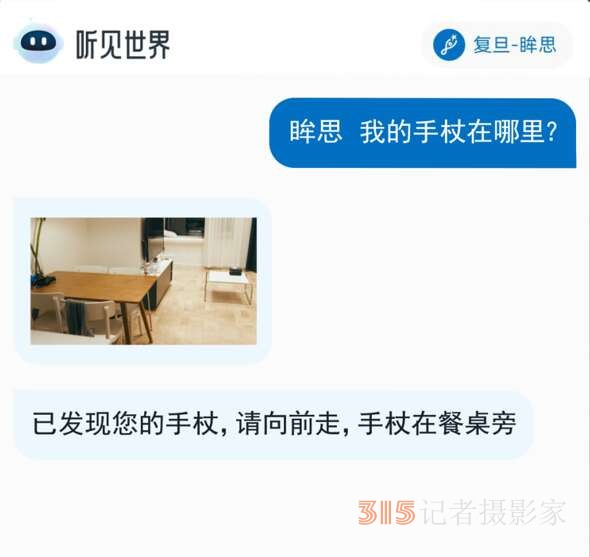

“听见世界”App有三种工作模式。一是街道行走模式,它可以细致扫描道路情况,发现红绿灯、十字路口、障碍物等,提示潜在风险;二是自由问答模式,它可以带着视障人士走进博物馆、艺术馆、公园,捕捉四周景象的每个细节,用声音构建生活场景;三是寻物模式,它可以及时帮助主人找到不知道被放在哪里的手杖、不同口味的牛奶等。

据悉,我国盲人数量有1700多万,但在街上很少看到盲人出行。一个重要的原因是他们出门要面对大量不安全因素,难以独自成行。

复旦大学自然语言实验室张奇教授介绍,“听见世界”App项目的主导者都是“初出茅庐”的学生,在组内头脑风暴会上,年轻学子总能提出开创性想法”。

该项目团队共计吸纳了从本科生到博士生共25名复旦学子以及桂韬等多位教师、专家的加入。为了更好地感受视障者的难处,团队成员同样模拟真实情境,蒙眼探索视障者“黑暗”世界,并邀请视障人士加入,进一步摸清真实而具体的需求。在基于几亿张图片训练出的“眸思”大模型基础上,针对视障者提出的各类需求,同学们又用上万张图片进行特殊样本训练,使“眸思”具备能够适配更多场景的能力。未来,该项目还会开发更多的使用模式,比如阅读模式,服务盲人朋友点菜、读书等场景;解说模式,承担无障碍电影解说员的工作。

(编辑:映雪)

体重轻就能半价旅游?提防“低价游”新套路

体重轻就能半价旅游?提防“低价游”新套路 扫码领“五险一金补贴”?当心,是诈骗!

扫码领“五险一金补贴”?当心,是诈骗! “内部指标”“证书挂靠”都是坑 警惕各种“求职陷阱”

“内部指标”“证书挂靠”都是坑 警惕各种“求职陷阱” 探秘 “银发专属健身房”:解锁老年健康社交新密码

探秘 “银发专属健身房”:解锁老年健康社交新密码